thelonervn

Active member

Tội phạm mạng cảm thấy bớt tội lỗi hơn bằng cách đổ lỗi cho AI.

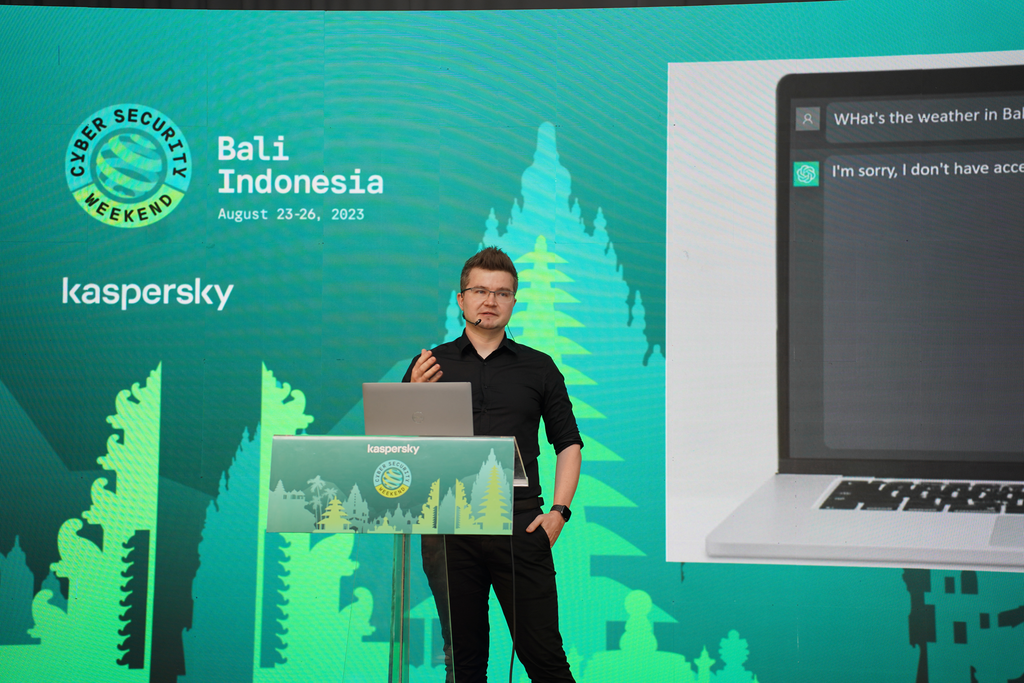

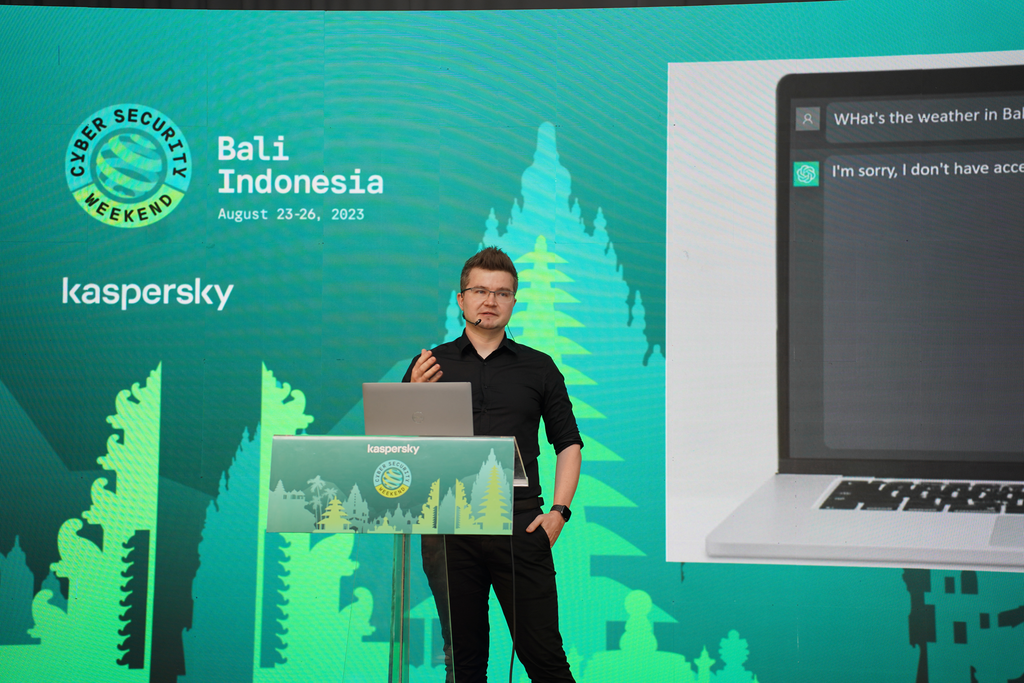

Chuyên gia Kaspersky đã có những chia sẻ xoay quanh phân tích về hậu quả có thể xảy ra của Trí tuệ nhân tạo (AI), đặc biệt là nguy cơ tâm lý tiềm ẩn của công nghệ này.

Ông Vitaly Kamluk, Giám đốc Nhóm Nghiên cứu và Phân tích toàn cầu (GReAT) khu vực châu Á - Thái Bình Dương của Kaspersky, tiết lộ rằng khi tội phạm mạng sử dụng AI để thực hiện hành vi phạm tội, chúng có thể đổ lỗi cho công nghệ này và cảm thấy ít phải chịu trách nhiệm hơn về hậu quả của cuộc tấn công mạng.

Điều này dẫn đến “hội chứng né tránh tội lỗi”

Ông Kamluk giải thích: “Ngoài những mối đe doạ liên quan đến công nghệ từ AI, mối nguy tiềm ẩn về tâm lý cũng đang tồn tại. Một hội chứng tâm lý phổ biến trong ‘cộng đồng’ những tên tội phạm mạng còn được biết đến với tên gọi ‘hội chứng né tránh tội lỗi’. Khi thực hiện các tấn công hoặc làm bị thương những người đi đường, kẻ phạm tội sẽ chịu áp lực tâm lý nặng nề từ việc chứng kiến trực tiếp hậu quả mà chúng gây ra. Tuy nhiên, điều này sẽ không được áp dụng đối với một tên tội phạm mạng ảo đang đánh cắp và tấn công một nạn nhân mà chúng không bao giờ nhìn thấy. Việc tạo ra AI mang lại tiền bạc hoặc lợi ích bất hợp pháp cho kẻ phạm tội một cách ‘thần kì’, tạo ra khoảng cách giữa tâm lý tội lỗi và hành vi phạm tội của chúng vì trên thực tế, người phạm tội không thực sự thực hiện hành vi, mà AI mới chính là chủ thể phạm tội”.

Một tác dụng phụ tâm lý khác của AI có thể ảnh hưởng đến các nhóm bảo mật CNTT là “ủy thác trách nhiệm”. Khi ngày càng có nhiều quy trình và công cụ an ninh mạng được tự động hóa và ủy quyền cho mạng nơ-ron nhân tạo, con người có thể cảm thấy ít phải chịu trách nhiệm hơn nếu một cuộc tấn công mạng xảy ra, đặc biệt là trong môi trường công ty.

Ông cho biết thêm: ”Có một hiệu ứng tương tự có thể áp dụng cho nhóm người bảo vệ, đặc biệt là trong lĩnh vực doanh nghiệp yêu cầu nghiêm ngặt về việc tuân thủ và trách nhiệm đảm bảo an toàn. Cụ thể, một hệ thống phòng thủ thông minh có thể trở thành “người quan sát”. Ngoài ra, sự ra đời của chế độ lái hoàn toàn tự động cũng làm giảm sự chú ý của người lái xe”.

Kamluk đã chia sẻ một số hướng dẫn để các nhóm bảo mật tận dụng lợi ích của AI một cách an toàn:

Các lập trình viên phần mềm phải được đào tạo về cách sử dụng công nghệ một cách có trách nhiệm và hiểu biết về hình phạt nếu lạm dụng AI.

Ông Kamluk cho biết thêm: “Một số người dự đoán rằng AI sẽ là mối đe dọa với sự tồn vong của loài người và là thứ sẽ hủy diệt nền văn minh nhân loại. Nhiều nhà điều hành cấp cao của các tập đoàn lớn thậm chí còn đứng lên kêu gọi giảm tốc độ hoạt động của AI để ngăn chặn thảm họa. Đúng là với sự phát triển của AI, chúng ta đã chứng kiến sự đột phá của công nghệ có thể tổng hợp nội dung tương tự như những gì con người làm: từ hình ảnh đến âm thanh, video deepfake và thậm chí cả các cuộc hội thoại dựa trên văn bản không thể phân biệt được với con người. Giống như hầu hết các đột phá công nghệ, AI là con dao hai lưỡi. Chúng ta luôn có thể tận dụng nó để làm lợi thế cho mình miễn là chúng ta biết cách đặt chỉ dẫn an toàn cho những cỗ máy thông minh này”.

Kaspersky sẽ tiếp tục thảo luận về tương lai của an ninh mạng tại Hội nghị thượng đỉnh phân tích bảo mật Kaspersky (SAS) 2023 diễn ra tại Phuket, Thái Lan, từ ngày 25 – 28/10/2023.

Sự kiện này chào đón các nhà nghiên cứu chống phần mềm độc hại tầm cỡ, các cơ quan thực thi pháp luật toàn cầu, Nhóm ứng phó khẩn cấp máy tính (CERT) và các Giám đốc Điều hành Cấp cao từ các dịch vụ tài chính, công nghệ, chăm sóc sức khỏe, học viện và các cơ quan chính phủ từ khắp nơi trên thế giới.

Chuyên gia Kaspersky đã có những chia sẻ xoay quanh phân tích về hậu quả có thể xảy ra của Trí tuệ nhân tạo (AI), đặc biệt là nguy cơ tâm lý tiềm ẩn của công nghệ này.

Ông Vitaly Kamluk, Giám đốc Nhóm Nghiên cứu và Phân tích toàn cầu (GReAT) khu vực châu Á - Thái Bình Dương của Kaspersky, tiết lộ rằng khi tội phạm mạng sử dụng AI để thực hiện hành vi phạm tội, chúng có thể đổ lỗi cho công nghệ này và cảm thấy ít phải chịu trách nhiệm hơn về hậu quả của cuộc tấn công mạng.

Điều này dẫn đến “hội chứng né tránh tội lỗi”

Ông Kamluk giải thích: “Ngoài những mối đe doạ liên quan đến công nghệ từ AI, mối nguy tiềm ẩn về tâm lý cũng đang tồn tại. Một hội chứng tâm lý phổ biến trong ‘cộng đồng’ những tên tội phạm mạng còn được biết đến với tên gọi ‘hội chứng né tránh tội lỗi’. Khi thực hiện các tấn công hoặc làm bị thương những người đi đường, kẻ phạm tội sẽ chịu áp lực tâm lý nặng nề từ việc chứng kiến trực tiếp hậu quả mà chúng gây ra. Tuy nhiên, điều này sẽ không được áp dụng đối với một tên tội phạm mạng ảo đang đánh cắp và tấn công một nạn nhân mà chúng không bao giờ nhìn thấy. Việc tạo ra AI mang lại tiền bạc hoặc lợi ích bất hợp pháp cho kẻ phạm tội một cách ‘thần kì’, tạo ra khoảng cách giữa tâm lý tội lỗi và hành vi phạm tội của chúng vì trên thực tế, người phạm tội không thực sự thực hiện hành vi, mà AI mới chính là chủ thể phạm tội”.

Một tác dụng phụ tâm lý khác của AI có thể ảnh hưởng đến các nhóm bảo mật CNTT là “ủy thác trách nhiệm”. Khi ngày càng có nhiều quy trình và công cụ an ninh mạng được tự động hóa và ủy quyền cho mạng nơ-ron nhân tạo, con người có thể cảm thấy ít phải chịu trách nhiệm hơn nếu một cuộc tấn công mạng xảy ra, đặc biệt là trong môi trường công ty.

Ông cho biết thêm: ”Có một hiệu ứng tương tự có thể áp dụng cho nhóm người bảo vệ, đặc biệt là trong lĩnh vực doanh nghiệp yêu cầu nghiêm ngặt về việc tuân thủ và trách nhiệm đảm bảo an toàn. Cụ thể, một hệ thống phòng thủ thông minh có thể trở thành “người quan sát”. Ngoài ra, sự ra đời của chế độ lái hoàn toàn tự động cũng làm giảm sự chú ý của người lái xe”.

Kamluk đã chia sẻ một số hướng dẫn để các nhóm bảo mật tận dụng lợi ích của AI một cách an toàn:

- Khả năng truy cập: Chúng ta phải hạn chế quyền truy cập ẩn danh vào các hệ thống thông minh thực sự được xây dựng và đào tạo trên khối lượng dữ liệu khổng lồ. Hãy lưu giữ lịch sử của nội dung được tạo ra và xác định cách tạo nội dung tổng hợp được định sẵn.

- Quy định: Liên minh châu Âu đã bắt đầu thảo luận về việc đánh dấu nội dung được tạo ra với sự trợ giúp của AI. Bằng cách đó, người dùng ít nhất sẽ có cách nhanh chóng và đáng tin cậy để phát hiện ra các hình ảnh, âm thanh, video hoặc văn bản được tạo ra bởi AI. Sẽ luôn có những kẻ phạm tội, nhưng chỉ là thiểu số và luôn phải chạy trốn.

- Giáo dục: Nâng cao nhận thức về cách phát hiện nội dung nhân tạo, cách xác thực nội dung đó và cách báo cáo hành vi lạm dụng có thể xảy ra là biện pháp hiệu quả nhất để đối phó với các tác nhân gây hại.

Các lập trình viên phần mềm phải được đào tạo về cách sử dụng công nghệ một cách có trách nhiệm và hiểu biết về hình phạt nếu lạm dụng AI.

Ông Kamluk cho biết thêm: “Một số người dự đoán rằng AI sẽ là mối đe dọa với sự tồn vong của loài người và là thứ sẽ hủy diệt nền văn minh nhân loại. Nhiều nhà điều hành cấp cao của các tập đoàn lớn thậm chí còn đứng lên kêu gọi giảm tốc độ hoạt động của AI để ngăn chặn thảm họa. Đúng là với sự phát triển của AI, chúng ta đã chứng kiến sự đột phá của công nghệ có thể tổng hợp nội dung tương tự như những gì con người làm: từ hình ảnh đến âm thanh, video deepfake và thậm chí cả các cuộc hội thoại dựa trên văn bản không thể phân biệt được với con người. Giống như hầu hết các đột phá công nghệ, AI là con dao hai lưỡi. Chúng ta luôn có thể tận dụng nó để làm lợi thế cho mình miễn là chúng ta biết cách đặt chỉ dẫn an toàn cho những cỗ máy thông minh này”.

Kaspersky sẽ tiếp tục thảo luận về tương lai của an ninh mạng tại Hội nghị thượng đỉnh phân tích bảo mật Kaspersky (SAS) 2023 diễn ra tại Phuket, Thái Lan, từ ngày 25 – 28/10/2023.

Sự kiện này chào đón các nhà nghiên cứu chống phần mềm độc hại tầm cỡ, các cơ quan thực thi pháp luật toàn cầu, Nhóm ứng phó khẩn cấp máy tính (CERT) và các Giám đốc Điều hành Cấp cao từ các dịch vụ tài chính, công nghệ, chăm sóc sức khỏe, học viện và các cơ quan chính phủ từ khắp nơi trên thế giới.